两天时间洞见未来五年

人工智能学习人类知识,同时也吸收人类偏见。这种担忧由来已久。但谷歌的一项新发明极大推进了人工智能从文本材料中学习的速度,也使解决机器偏见问题迫在眉睫。

10 月 25 日,谷歌宣布利用 BERT 来优化搜索引擎,已经使英语搜索结果的匹配度提高了 10% 左右。未来,谷歌还会推出学习其他语言和国家的算法。

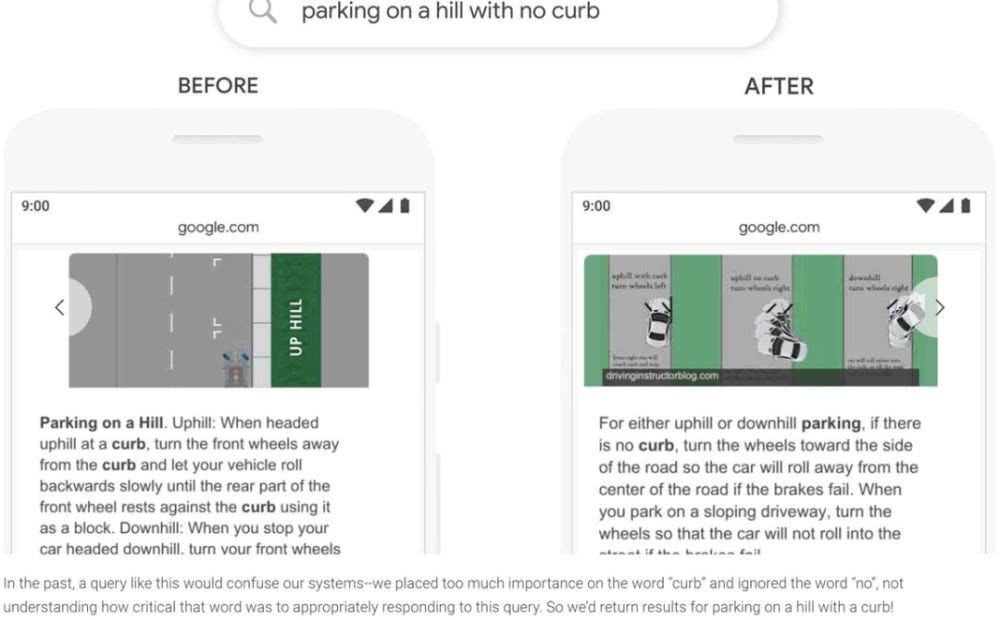

BERT 是谷歌在 2018 年开发的一种基于神经网络的 NLP 技术,它能一次接收整句话,而非从左至右(或相反)逐字接收。这使得如果有人要搜“在没有路缘的山坡停车”,BERT 能认出“不要”,从而给出正确的搜索结果。而传统搜索引起只会关注“路缘”和“山坡”,给出与搜索意图相反的结果。

图 | BERT 能更好识别“在没有路缘的山坡停车”句子里的“没有”一词,从而理解人类意图(来源:https://blog.google)

让人们担忧的是,BERT 的学习材料正来自数字化书籍和新闻文章。在 BERT 学会一切之前,人们没有时间来清理其中根深蒂固的偏见。而这些偏见一旦被算法吸收,将更难辨认,也更难清除。

“形象一下在 AI 世界长大的孩子。他们在谷歌搜索 CEO 照片,冒出的大部分是男性。他们又搜索个人助手,大部分是女性。”Kriti Sharma 在一次 TED 相关演讲中说。卡耐基梅隆大学的计算机科学家已研究证实,BERT 倾向于将程序员与男性联系起来。

另一位计算机科学家 Robert Munro 发现,展示给 BERT 100 个单词,包含马、婴儿、房子、珠宝等。BERT 会认为大部分与男性有关,仅妈妈是个例外。

“BERT 改变了一切,你可以教它所有技巧。”NLP 初创公司 Primer 的科学主管 John Bohannon 说。Munro 则认为,不平等现象一直存在,但有了 BERT,偏见就能够继续存在下去。

“是时候把算法当作人类设计的造物了。”人工智能批评人士 Kate Crawford 说,算法经常被看作是不带偏见、不可理解、勿需质疑的对象,但实际它会继承我们的偏见,它只可能跟我们一样好。

决策黑盒为偏见“藏污纳垢”

人们最初确实天真地以为,算法能比人类更能避免偏见。1970 年代,伦敦圣乔治医学院的 Geoffrey Franglen 博士着手编写一个算法来筛选学生的入学申请。他认为,如果所有学生的申请都要遵循完全一样的评估流程,结果就是公平的。

算法完成后与人类判断有 90% 到 95% 的一致率,因此被投入使用。但直到 4 年后,调查者才发现:算法会仅仅因为一个候选人没有欧洲名字(可能不是白人),就扣除 15 分。如果申请者是女性,又要被扣掉 3 分。

“从深层次看,算法只是在维持招生系统早已存在的偏见而已。”IEEE 的文章评论说,“圣乔治医学院之所以被逮住,是因为他们把偏见供奉到一个计算机程序里面,歧视是调查者可以验证的。”

但对于人工智能的黑箱式决策,情况变得更加复杂。性别或出生地在算法中并不对应单一可辨的参数,你很难给机器“定罪”。“在大工业时代,机器以暴露齿轮来展示强大。但如今,齿轮被隐藏起来,融入生活,无处不在,AI 就是这个齿轮。”一篇《福布斯》文章精辟地说。

在这种黑箱决策面前,反歧视法案可能也无能为力。Kriti Sharma 认为,如果 AI 帮人事主管寻找一位技术领袖,它会发现主管雇佣的大多是男性,从而以为男人比女人更容易编程。如果人类主管这样做,我们会愤怒,也能够阻止。“人工智能实际已凌驾于法律之上,因为是机器做的决定。”

更值得担忧的是,AI 决策可能放大了科技企业和数据标注者的权力,因为无人能监督。一个名为 ImageNet Roulette 的流行应用,曾故意向人们展示这种风险:它曾倾向于将非洲裔美国人标记为“不法分子”“罪犯”,此外还有“失败者”“初学者”“荡妇”这样的标签。

图 | ImageNet 展示了为人们打上刻板标签的权力,如何从拿低薪的标注者手中转移到算法上(来源:frieze.com)

它的训练数据来自 ImageNet 数据集,包含了 1400 张被标记的照片,而每张标记费用为几美分。因此标签标注者的偏见便被带入数据集,训练出各种算法,应用在形形色色的领域。“如果标注女性照片的人不选非二元人群或短发女性,那最终得到的人工智能就只认长发的女性模特。”

在被发现算法存在机器偏见时,谷歌和亚马逊都会承诺迅速解决。“我们发现的明显的偏见,但里面如果还有几个呢?”Bohannon 博士说。如果要依赖这种决策,“正如生物学家努力理解细胞工作原理一样,软件工程师也必须找到理解 BERT 系统的方法。”

人人都要学会讨好算法

电影《少数派报告》里,汤姆克鲁斯负责抓捕那些被电脑认为“将要犯罪”的人,直到有一天自己也上了抓捕名单。在现实中,类似的系统可能已经上线。

据 BBC 报道,2017 年 5 月,英国达勒姆警方启用了一套系统。它学习过警方 5 年关押报告和 2 年定罪报告,来预测嫌疑人犯罪的可能性是低、中、高,以决定是否收押。

但使用数年后,评估工具发现,这套系统认为黑人是罪犯的概率是白人的两倍,还喜欢把白人定为低风险、单独犯案。此外,它预测低风险犯罪的准确率为 98%,高风险为 88%,暗示它宁错抓一千、不错放一人。

2016 年 12 月,迪拜警方也启用了一套系统,来预测不同地区犯罪概率,将警力部署在高风险地区加强巡逻。

如果说预测犯罪尚遥远,AI 招聘则掌握了你的生杀大权。11 月初,高盛、希尔顿和联合利华等企业都开始使用一种名为 HireVue 的 AI 视频面试系统,并赞赏有加。希尔顿高管说,HireVue 将招聘周期从 6 周缩短到了 5 天。

图 | 学会讨好 HireVue 的算法有望成为求职者的必备技能(来源:softwareadvice.com )

但它的决策偏好被发现匪夷所思:AI 分不清你皱眉是因为在思考问题,还是情绪不佳(暗示性格易怒)。面试者既担心表现,又不知 AI 如何给自己打分,以至于刻意迎合 AI:在面试全程表情微笑、放慢语速、在摄像头边贴上眼睛贴纸,以维持眼神接触,以及让背后是一堵白墙,防止干扰算法。

此外,HireVue 也被认为加强了求职偏见:机器通过学习现有员工来寻找新员工。这意味着如果一个部门所有员工全是白人(即使是巧合),AI 也会不自觉地偏向寻找白人。如果好员工恰都是女性,那么男性面试者也会被降低权重。

“我们迎来了焦虑的一代,要求他们面向屏幕说话,对摄像头回答问题,还不告诉他们如何做得更好。”辅导学生参加 HireVue 面试后,杜克大学经济学教授 Emma Rasiel 表示。不难想象,如果你能骗过 AI 面试,也许会尝试用匪夷所思的举动骗过其他 AI 决策。

-End-

参考:

https://www.nytimes.com/2019/11/11/technology/artificial-intelligence-bias.html?auth=login-email&login=email

https://www.nytimes.com/2019/09/20/arts/design/imagenet-trevor-paglen-ai-facial-recognition.html?action=click&module=RelatedLinks&pgtype=Article

https://blog.google/products/search/search-language-understanding-bert/

https://www.bbc.com/news/technology-39857645

https://www.ted.com/talks/kriti_sharma_how_to_keep_human_biases_out_of_ai/transcript?language=zh-cn